Comment fonctionne Google

Dans un univers numérique saturé d’information, les moteurs de recherche sont devenus des piliers indispensables pour accéder rapidement à des contenus pertinents. Google, véritable chef de file du secteur, transforme chaque requête en une réponse fluide et personnalisée. Mais que se passe-t-il réellement en coulisses ? Derrière son interface épurée se cache une architecture technologique sophistiquée : exploration, indexation, tri, puis restitution, chaque étape est optimisée pour répondre au mieux aux intentions de recherche des internautes.

Cet objectif de pertinence conduit Google à faire évoluer sans cesse ses algorithmes et ses infrastructures. Face à des défis tels que la lutte contre la désinformation, la gestion de milliards de données en temps réel, ou encore la diversité des profils utilisateurs, Google s’ajuste de manière continue. D’autres moteurs comme Bing, DuckDuckGo ou Qwant proposent des approches alternatives, enrichissant ainsi la concurrence et stimulant l’innovation.

Pour saisir le fonctionnement profond de Google, il faut comprendre les grandes étapes techniques de son traitement de l’information : l’exploration des pages web (crawling), leur classement et organisation (indexation), leur hiérarchisation dans les résultats (ranking), et enfin l’affichage des pages pertinentes (restitution). Ce processus s’appuie sur des technologies de pointe, rendant la recherche non seulement plus rapide, mais aussi mieux ciblée et plus intelligente.

Exploration du web : comment Google cartographie Internet

L’exploration, appelée aussi crawling, est la toute première phase du processus. Des robots appelés Googlebots scannent en permanence l’ensemble du web pour découvrir, analyser et récupérer de nouvelles ressources disponibles en ligne. Ces explorateurs ne se limitent pas aux pages textuelles : ils parcourent également les images, documents, vidéos et autres contenus multimédias.

Pour supporter cette tâche titanesque, Google exploite un puissant réseau mondial de serveurs répartis stratégiquement. Les crawlers naviguent de lien en lien, formant une arborescence infinie qui suit les connexions entre les pages et ressources. Lorsqu’un site est mis à jour ou qu’un nouveau domaine apparaît, les Googlebots en tiennent compte pour mettre à jour l’index de recherche.

- Identification automatique des liens internes et externes

- Fréquence d’exploration adaptée selon l’actualité ou la popularité du site

- Respect des directives robot.txt fixées par les webmasters

- Priorisation de contenu à fort intérêt pour les utilisateurs

Les crawlers peuvent parfois rencontrer des difficultés, notamment face à des pages inaccessibles, du contenu dupliqué, ou des barrières techniques. Ces anomalies sont analysées pour affiner continuellement l’efficacité du crawling. Si d’autres moteurs appliquent des méthodes similaires, Google se distingue par la robustesse, la rapidité et la précision de son exploration.

| Phase d’exploration | Description | Impact sur la recherche |

|---|---|---|

| Découverte des URLs | Suivi automatique des liens disponibles | Enrichissement permanent du contenu connaissant |

| Répétition dynamique | Fréquence ajustée selon les modifications | Actualisation des données affichées |

| Directives respectées | Exclusion de contenus via robots.txt | Éthique du respect de la vie privée des sites |

| Gestion proactive des erreurs | Détection des pages défectueuses ou redondantes | Nettoyage de l’index pour une meilleure expérience |

Le fruit de cette exploration est un index imposant, comparable à la plus vaste bibliothèque du monde, qui grandit et s’actualise sans cesse. Cela permet à Google de répondre en temps réel à des demandes toujours plus précises (source officielle).

Les autres moteurs et leurs particularités dans l’exploration

Bien que Google domine le secteur, Bing, Yahoo, DuckDuckGo ou encore Qwant utilisent également leurs propres crawlers. Chacun affiche des priorités différentes : la confidentialité pour DuckDuckGo, la souveraineté européenne pour Qwant, ou encore l’intégration de données locales dans le cas de Yandex ou Seznam.

Ces moteurs adoptent parfois des approches techniques propres, mais tous partent du même principe fondamental : sans exploration efficace et continue, impossible d’offrir des résultats pertinents aux utilisateurs.

Indexation : l’organisation des données collectées

Une fois les données collectées, elles sont organisées et classées au sein de l’index de Google, une base de données gigantesque optimisée pour permettre un accès rapide. Cette bibliothèque numérique catégorise les contenus en fonction de leur structure, leur qualité, leur sujet et de nombreux autres critères.

- Analyse sémantique du texte pour identifier les principales thématiques

- Extraction des métadonnées comme les auteurs, les dates, et les formats

- Traitement automatique du langage naturel pour comprendre le contexte

- Détection des contenus dupliqués pour éviter la redondance

- Évaluation de la réputation du site via les liens externes

L’intelligence artificielle joue ici un rôle capital. Grâce à des modèles avancés de compréhension du langage (comme BERT), Google parvient non seulement à indexer des mots, mais aussi à comprendre l’intention derrière des phrases complexes, des synonymes ou expressions idiomatiques.

| Méthode d’indexation | Fonction | Résultat attendu |

|---|---|---|

| Extraction de mots-clés | Détermination des termes essentiels | Catégorisation correcte des contenus |

| Analyse contextuelle | Compréhension des intentions et synonymes | Affinage de la pertinence |

| Gestion des métadonnées | Recensement d’informations complémentaires | Enrichissement de l’index |

| Élimination des doublons | Repérage des contenus en double | Fluidité et efficacité de la recherche |

Quand l’IA révolutionne l’indexation

Avec l’apparition de technologies comme BERT et MUM, Google introduit une capacité croissante à interpréter des idées complexes et des recherches nuancées. En parallèle, ces systèmes contribuent aussi à détecter les pratiques abusives, combattre le spam, et promouvoir des résultats plus fiables.

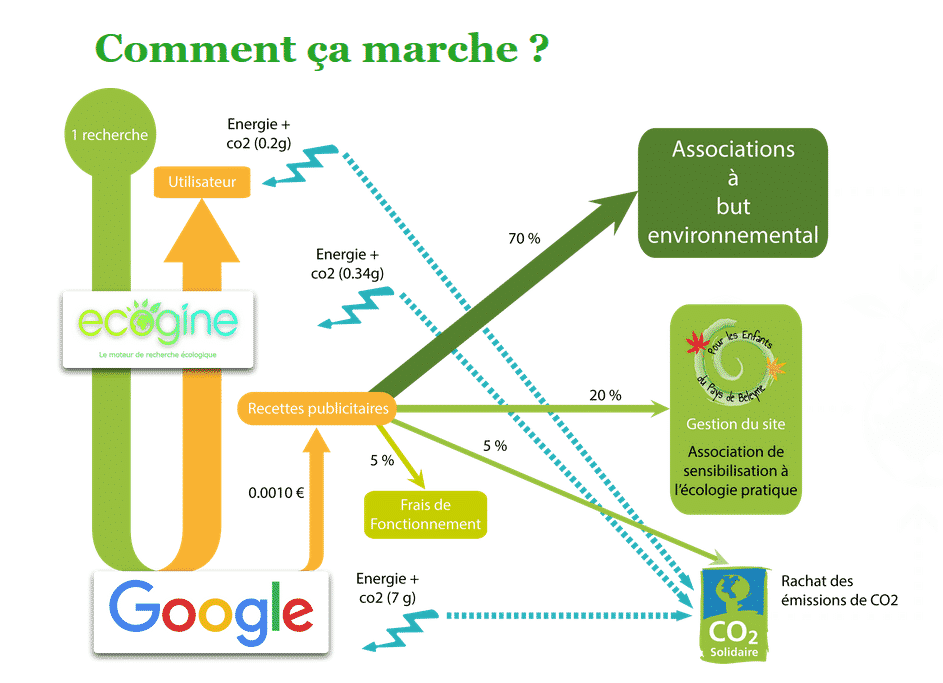

D’autres acteurs, dont Yandex, Ecosia ou Seznam, utilisent également des stratégies d’indexation mixtes pour répondre à leurs objectifs spécifiques – qu’ils soient liés à la langue, à l’écologie ou à l’accès localisé à l’information.

Classement des résultats : qui décide ce que vous voyez ?

Après l’indexation, vient le moment de hiérarchiser l’information. C’est le rôle du ranking (classement), qui repose sur plusieurs centaines de critères algorithmiques permettant de mesurer la pertinence d’une page pour une requête donnée.

Parmi les algorithmes phares figure PageRank, conçu pour évaluer la popularité d’une page via les liens entrants. Des signaux comme la qualité du contenu, l’expérience utilisateur, la vitesse de chargement ou encore l’adaptabilité mobile sont également pris en considération.

- Contenu original, complet et actualisé

- Taux de clics et temps passé sur la page

- Ergonomie sur mobile

- Temps de chargement rapide

- Localisation de l’utilisateur et historique web

| Élément analysé | Rôle | Impact sur le classement |

|---|---|---|

| Qualité des backlinks | Popularité du site référent | Très important |

| Contenu pertinent | Réponse exacte à l’intention de recherche | Élevé |

| UX globale | Comportement de l’internaute | Moyen à fort |

| Optimisation mobile | Accessibilité sur smartphone | Prioritaire |

| Performances techniques | Chargement rapide | Élevé |

Affichage des résultats : de la requête à la réponse

Lorsqu’un internaute saisit une requête, Google engage immédiatement le processus de restitution. En quelques millisecondes, il interprète les mots utilisés en tenant compte de leur signification potentielle, du contexte personnel de l’utilisateur, et des signaux de pertinence établis en amont.

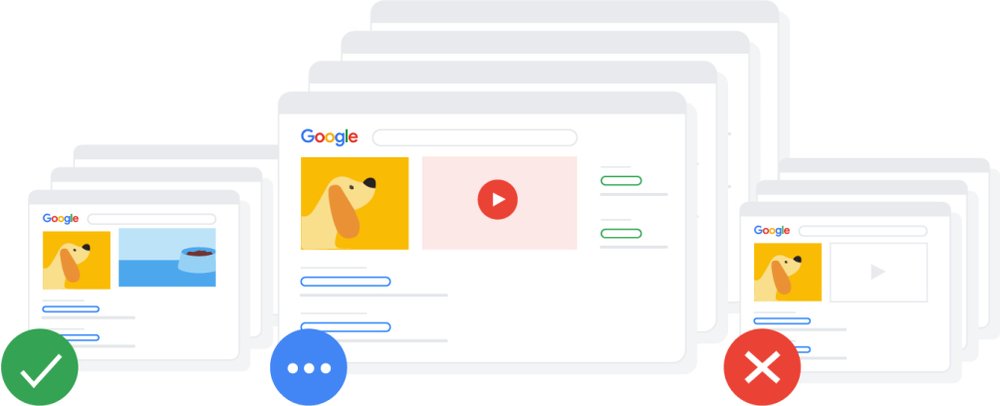

La réponse peut aller bien au-delà d’un simple lien : extraits enrichis, images, vidéos, cartes, actualités ou widgets (comme la météo ou une calculatrice) sont désormais monnaie courante.

- Compréhension sémantique des mots clés

- Personnalisation selon la situation de l’utilisateur

- Multiplicité de formats de résultats affichés

- Accès direct à certaines réponses via les featured snippets